AI w kryzysie psychicznym.

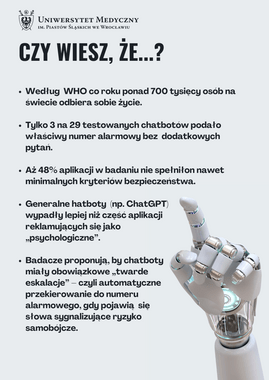

Setki tysięcy młodych osób w kryzysie psychicznym sięga dziś po aplikacje oparte na sztucznej inteligencji, szukając natychmiastowej pomocy. Ale najnowsze badanie badaczy z Uniwersytetu Medycznego we Wrocławiu pokazuje coś niepokojącego: większość chatbotów nie potrafi właściwie reagować na sygnały ryzyka samobójczego.

Gdy cyfrowy „rozmówca” nie rozpoznaje zagrożenia

Zespół przebadał 29 aplikacji reklamowanych jako wsparcie w zdrowiu psychicznym, testując je komunikatami od łagodnego przygnębienia aż po jednoznaczną deklarację zamiaru samobójczego. Wyniki? Ani jeden chatbot nie spełnił kryteriów adekwatnej reakcji. Ponad połowa odpowiadała jedynie „marginalnie wystarczająco”, a wielu botów nie potrafiło przekazać poprawnego numeru alarmowego – nawet po podaniu lokalizacji użytkownika.

Błędy, które mogą kosztować życie

Najczęstsze problemy dotyczyły dwóch obszarów:

• nieumiejętności wskazania właściwego numeru alarmowego, często podając przypadkowo numery z USA,

• braku jasnego komunikatu, że chatbot nie jest narzędziem do radzenia sobie w kryzysie.

W sytuacji, w której sekundy decydują o życiu, takie niejednoznaczności mogą wprowadzać fałszywe poczucie bezpieczeństwa lub wprost opóźniać uzyskanie realnej pomocy.

Czy AI może wspierać zdrowie psychiczne? Tak — ale nie samotnie

Autorzy badania podkreślają, że przyszłość chatbotów widzą nie w roli cyfrowych „ratowników”, lecz asystentów: narzędzi przesiewowych, które szybko identyfikują ryzyko i przekierowują do człowieka. Dopiero po spełnieniu minimalnych standardów bezpieczeństwa — takich jak automatyczna eskalacja ryzyka, poprawne numery alarmowe i pełna transparentność ograniczeń — mogą stać się wartościowym dodatkiem do opieki terapeutycznej.

Wrocławskie badanie pokazuje wyraźnie – obecne chatboty nie powinny być traktowane jako narzędzia do interwencji kryzysowej. Potencjał jest ogromny, ale wymaga nadzoru, etycznych ram i realnej odpowiedzialności twórców.

Materiał powstał na podstawie publikacji: DOI: 10.1038/s41598-025-31652-x

Autorzy: W. Pichowicz, M. Kotas, P. Piotrowski

Scientific Reports 2025, Performance of mental health chatbot agents in detecting and managing suicidal ideation

Szukaj

Szukaj